Typologie von High Potentials statt Kompetenzen

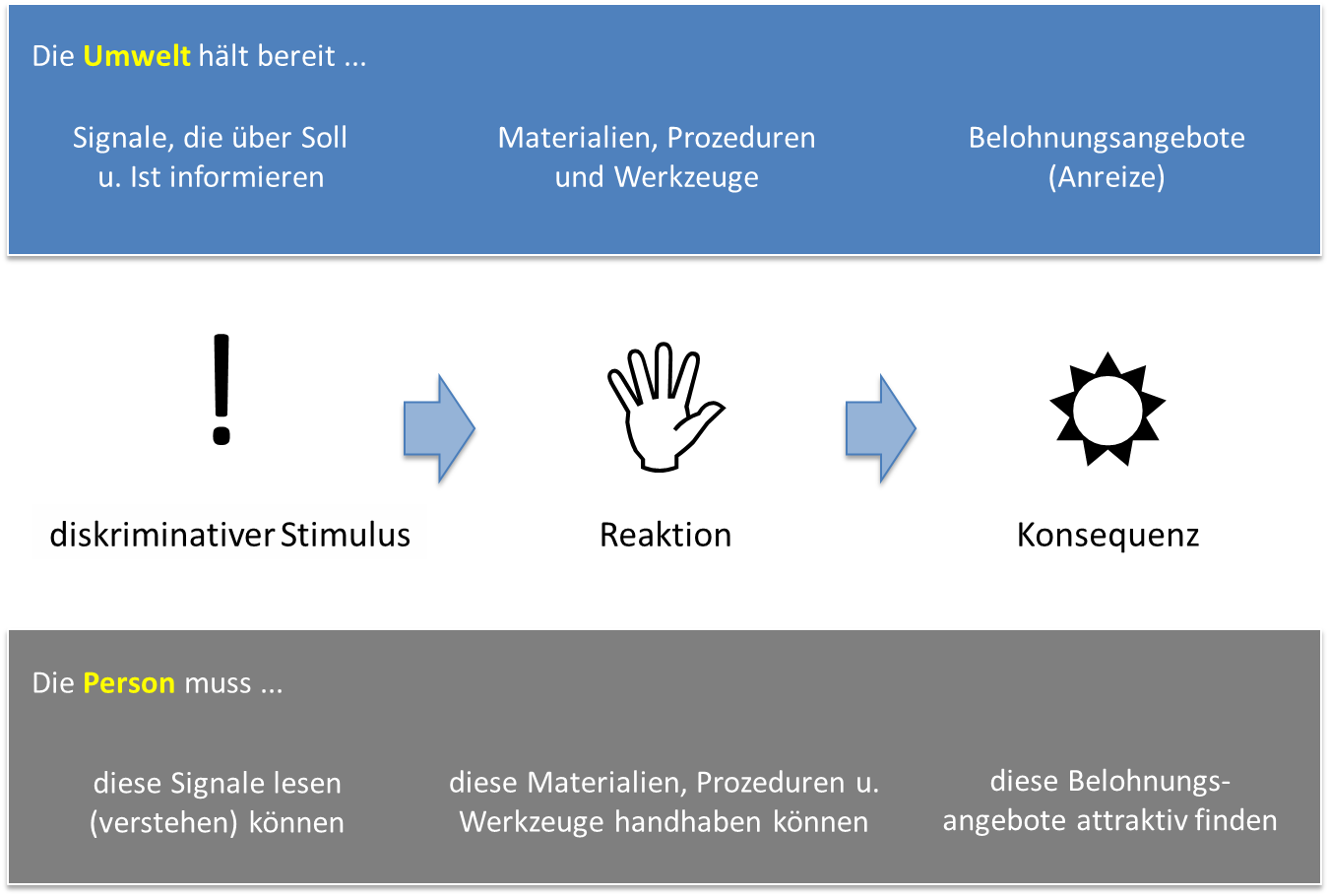

Jeff Conte von der San Diego State University (2014) präsentiert einen neuen Ansatz, um High Potentials in Unternehmen zu identifizieren. Der Ausgangspunkt besteht darin, dass einzelne isolierte Potenzialindikatoren oder Persönlichkeitsfaktoren nur mäßige Korrelationen in der Prädiktion von Aufstieg in Führung aufweisen. Die Korrelationen liegen maximal zwischen r = .20 und r = .30: Der monokausale Schluss von einem Persönlichkeitskriterium auf Erfolg im Beruf funktioniert also kaum. In der Psychologie gibt es neben dem Blick auf Menschen über Persönlichkeitskriterien und Kompetenzen auch den anderen Blick über Typologien (Freud, Jung). Auf der Basis einer statistischen Analyse (Latent Profile Analysis) hat Conte Muster in der Kombination von Persönlichkeitskriterien identifiziert und daraus eine solche Typologie vorgestellt (vgl. Abb. Hipo-Typologie). Die Basis besteht immerhin aus N = 25.000 Potenzialkandidaten, die in ihren Karrieren beobachtet wurden. Die klassischen Big-Five-Persönlichkeitskriterien wurden nach auffälligen Mustern untersucht, die mit Aufstieg in Führung zusammenhängen. Danach sind es nicht einzelne Big-Five-Kriterien, sondern es ist eine Kombination von Kriterien, die er als den resilienten Typen bezeichnet: Hohe Belastbarkeit, Genauigkeit/Leistungsstreben, moderate Extraversion und Geselligkeit. Die beiden anderen Typen (Over-/Undercontroller) hingegen sind eher nicht mit Erfolg oder Aufstieg in Führung assoziiert.

![Bild1]()

Hipo-Typologie San Diego University (Conte, J., 2014)

Soll ethisches Verhalten bei Bewerbern explizit überprüft werden?

In den USA hatte die Überprüfung der Integrität schon immer eine höhere Bedeutung – bei uns löst das Ansinnen zunächst Stirnrunzeln aus. Die Empirie zeigt allerdings, dass die Messung von Integrität ein starker Prädiktor für verschiedene Joberfolgskriterien ist. Dabei scheint es auf die Branche anzukommen: Interessante Branchen sind der Einzelhandel, die Logistik und die Produktion. In diesen Branchen gibt es substanzielle Verluste durch Mitarbeiterdiebstahl, die bei besserer Mitarbeiterauswahl verhindert werden können (Cooper, D. et al., 2014).

Erstaunlich ist, dass für diese Zielgruppe auch scheinbar durchschaubare Items eine hohe Validität besitzen, z. B. „Wenn Sie die letzten zwei Jahre zusammenfassen, was war der Wert der Dinge außer Kleinigkeiten wie Stifte, die Sie von der Firma für privaten Gebrauch mitgenommen haben?“. Weniger offensichtlich sind Items wie „Ich habe im letzten Jahr während der Arbeit nie impulsiv reagiert“. Items, die auch gut funktionieren, sind Rationalisierungen von unethischem Verhalten: „Nur wenn die Arbeitsbedingungen wirklich frustrierend sind, kann man auch mal etwas für den privaten Gebrauch mitnehmen“.

Integrität und ethisches Verhalten umfassen unterschiedliche Einzelfacetten, die je nach Anforderungen im Detail ausgewertet werden können: Einstellung gegenüber Arbeitssicherheit, Impulsivität, Einstellung gegenüber Qualität, Bereitschaft, vertrauliche Informationen zu behalten, Umgang mit Alkohol/Drogen. Es bestehen hohe Zusammenhänge zwischen ethischem Verhalten und den Big-Five-Kriterien Gewissenhaftigkeit (r = .51) und Soziabilität (r = .27) (Ones, S. et al., 2014).

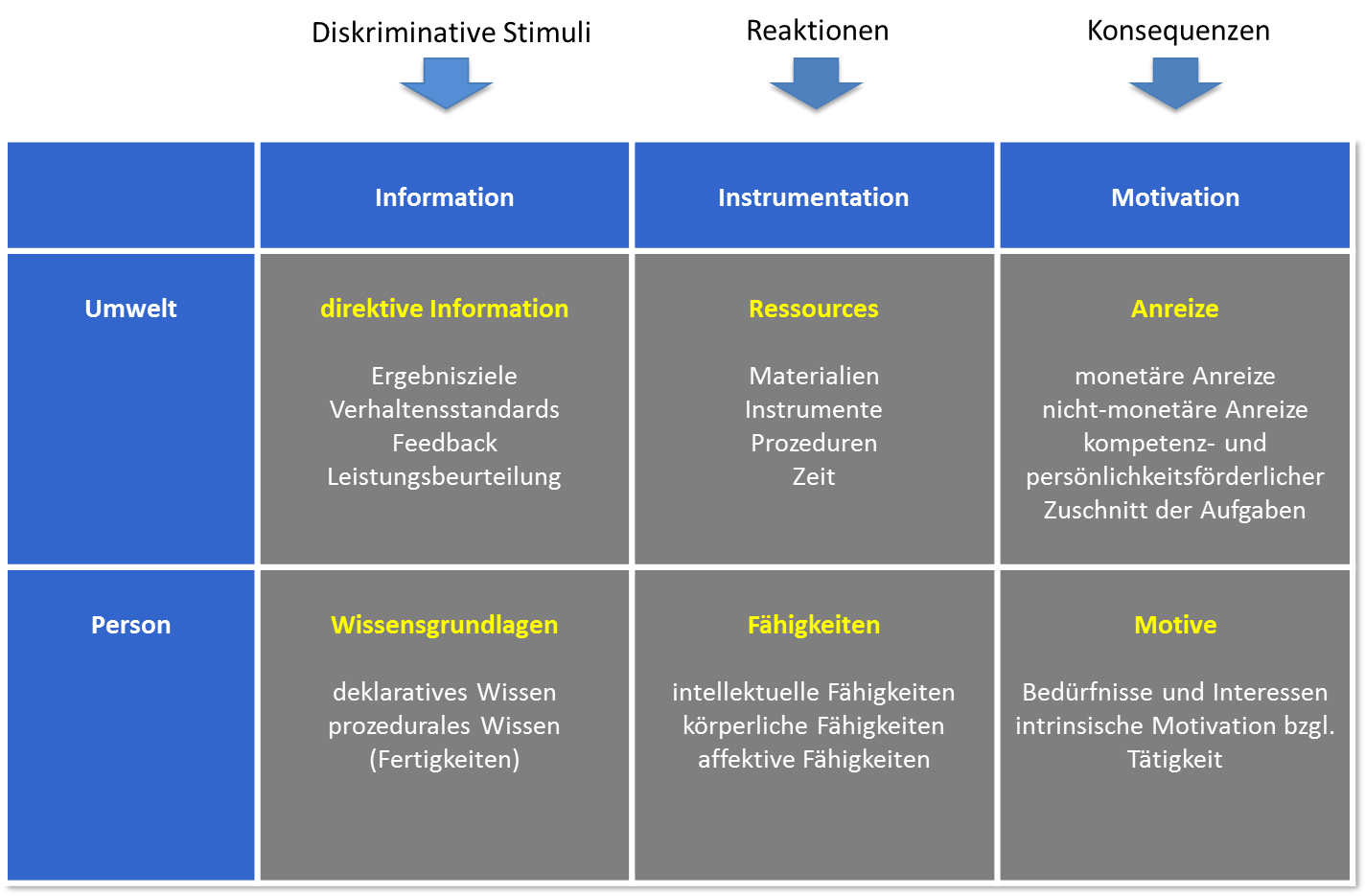

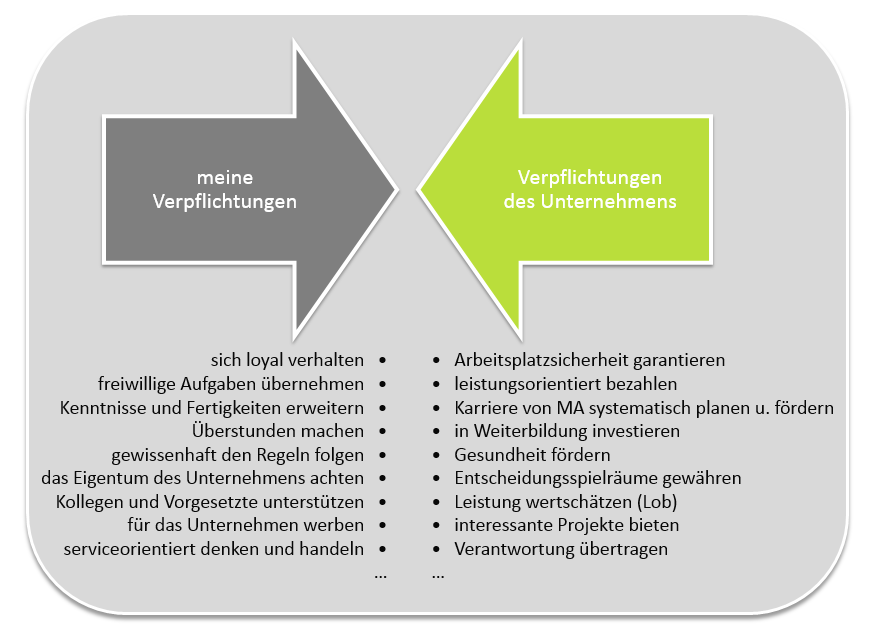

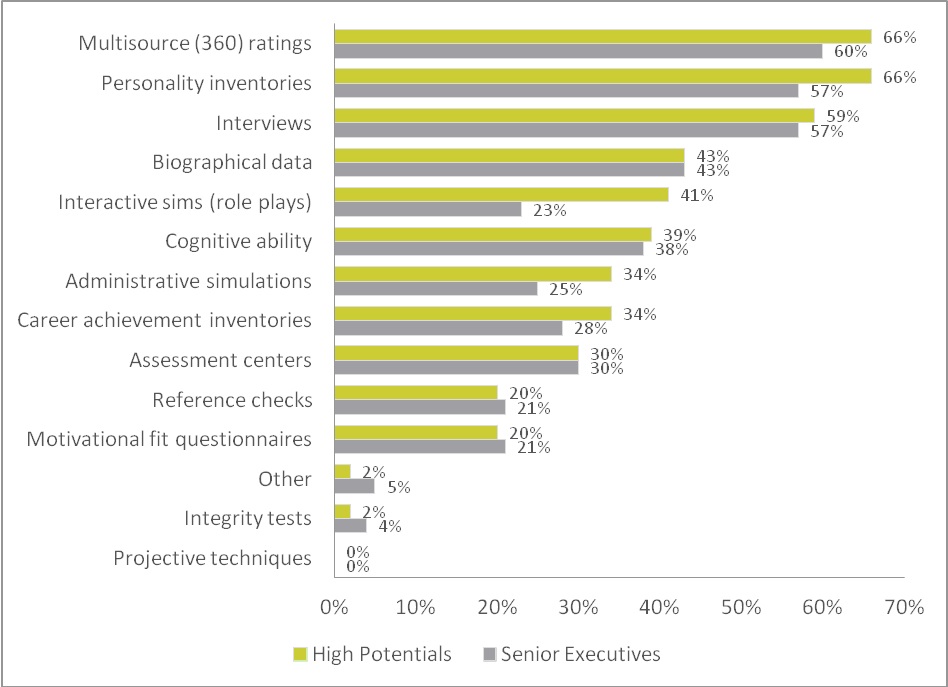

![Bild2]()

Interviewfragen zu ethischem Verhalten

Auch auf Management-Level hat das Konstrukt Relevanz. In einer Metaanalyse zu 25 Firmen in den Jahren 1985 bis 2012 konnte gezeigt werden, dass zwischen der in Fragebögen erhobenen Zuverlässigkeit von Managern ein Zusammenhang zur Beschäftigungsdauer und zur Performance-Einschätzung besteht (Pickering, D., 2014).

In einer weiteren aktuellen Untersuchung wurde die Integrität in verschiedenen Ländern verglichen – neben dem Mittelwert ist die Varianz der Werte innerhalb der Länder interessant (Ones, S. et al., 2014). In die Studie gingen 48 Länder mit 239.000 Teilnehmern ein. Die Ergebnisse entsprechen weitgehend bestehenden Stereotypen zu einzelnen Ländern, wobei US-Mitarbeiter nach der Studie angeblich ein hohes Level an Integrität haben. Wir Deutsche schneiden laut der Untersuchung im Mittel als etwas unethischer ab als die US-Amerikaner. Interessant für die Testung von ethischem Verhalten: Je höher die Varianz von ethischem Verhalten innerhalb eines Landes (oder einer Jobgruppe) ist, desto eher eignet es sich für die Vorhersage von Berufserfolg, in der Spitze mit Validitäten von r = .59 (Ones, S. et al., 2014).

Wer lügt, ist erfolgreich – Umgang mit sozial erwünschten Antworten in Testverfahren

Ein fortwährendes Thema in Studien ist die Frage, wie mit sozial erwünschten Antworten oder gar „Faking“ in Testverfahren umgegangen werden soll. Nach einzelnen Aussagen gehen 15 % bis 45 % der Varianz auf Faking oder sozial erwünschte Antworten in den klassischen Likert-Skalen zurück. Die früher übliche „Lügen-Skala“ mit Items wie „Ich habe noch niemals die Unwahrheit gesagt“ hilft nicht weiter, da mit den hier auffälligen Bewerbern („Ich habe noch nie gelogen“) keiner den Aufwand betreiben möchte, ein Nachinterview zu führen („Haben Sie die Wahrheit gesagt?“).

Der klassische Weg, sozial erwünschte Antworten zu verhindern, besteht in dem „Forced-Choice“-Format, das bei Obermann Consulting auch in dem Big-Five-Wirtschaft-Fragebogen eingesetzt wird. In dem Forced-Choice-Format werden den Kandidaten paarweise Antwortmöglichkeiten präsentiert, zwischen denen sie auswählen können oder sie nehmen ein Ranking der angebotenen Varianten vor („Was beschreibt mich am besten?”). Die angebotenen Varianten können entweder zu gleichen oder zu unterschiedlichen Dimensionen – so bei unserem Fragebogen Big-Five-Wirtschaft – gehören. Dabei ist in der Konstruktion darauf zu achten, dass die Alternativen jeweils gleich sozial erwünscht sind.

Eine andere Lösung, um sozial erwünschte Antworten zu kontrollieren, präsentieren Meade, A. W. et al. (2014). Die Kernidee besteht darin, dass die Items sehr kurz sind und dadurch die Kandidaten spontaner und weniger sozial erwünscht antworten. Ein typisches Item wäre „Dominant – so bin ich/so bin ich nicht“. Die Antwortzeit ist auf 2,5 Sekunden beschränkt, wobei kaum eine Testperson so weit kommt. Der Mittelwert der Antwortzeit beträgt eine Sekunde. Auf diese Weise kann der Test in zwei Minuten durchgeführt werden – dies stellt einen weiteren Vorteil dar. In einem experimentellen Design wurden Probanden gebeten, entweder ehrlich zu antworten oder sich bewusst positiv darzustellen. Gleichzeitig wurde die Testform variiert: Items der üblichen Länge oder die sehr kurzen Items. Ergebnis: In der „Faking-Bedingung“ bei der klassischen Testform gibt es einen bedeutsamen Unterschied zwischen der ehrlichen und unehrlichen Variante von d = 1,35. Wird hingegen die Form mit kurzen Items eingesetzt, sinkt der Unterschied auf d = 0,35. Scheinbar also ein vielversprechender Weg. Auf einen ähnlichen Ansatz beruht unser Fragebogen Big-Five-Wirtschaft, hier sind die Items sehr kurz und es muss unter ähnlich attraktiven Adjektiven eine Auswahl vorgenommen werden.

In einem weiteren neuen Artikel gehen Voss et al. (2014) der Frage nach, ob sozial erwünschte Antworten grundsätzlich zu verdammen sind. Neben bewusstem Täuschen können solche Antworten auf das akzeptable Motiv zurückzuführen sein, sich positiv zu präsentieren oder auf die weniger akzeptable aber ethisch kaum zu verdammende Tatsache eines inadäquaten Selbstbilds. In ihrer Untersuchung anhand von N = 101 Bewerbern bei BMW wurden in einem Big-Five-Fragebogen Eigeneinschätzungen den Bewertungen von jeweils drei Freunden gegenübergestellt. Interessantes Ergebnis: Die Bewerber mit einer gegenüber den Freunden zu positiven Eigeneinschätzung sind tendenziell gerade die später erfolgreichen Bewerber. Fazit: Sozial erwünschtes Antworten scheint auch im Job gefragt zu sein.

Innovationen bei biografischen Fragebögen

In Interviews nach bisherigen Erfahrungen zu fragen, war in der Praxis der Personalauswahl bisher schon immer die Basis aller Methoden. Die Begründung dafür liegt in dem Ansatz, dass die Vergangenheit der beruflichen Biografie der beste Prädiktor für zukünftigen Erfolg darstellt.

Eine Variante sind biografische Fragebögen. Die Idee besteht darin, online oder über Papier systematisch biografische Informationen abzufragen, zu denen zuvor ein empirischer Zusammenhang zu Joberfolgskriterien nachgewiesen wurde. Bei der Polizei des Landes NRW hat sich etwa die folgende Frage als sehr vorhersagestark erwiesen: „Wie viele Mobilfunkverträge haben Sie bisher in Ihrem Leben abgeschlossen?“. Bewerber, die wenige Mobilfunkverträge abgeschlossen haben, erwiesen sich im anschließenden Auswahlverfahren als erfolgreicher. Im Kontext von berufserfahrenen Bewerbern wäre etwa eine Frage: „Wie viele Projektgruppen haben Sie in den letzten fünf Jahren geleitet? a) keine b) 1-2 c) 3-5 d) > 6“. Die Begründung dafür zählt letztlich nicht, solange die Fragen nachgewiesenermaßen später erfolgreiche Bewerber vorhersagen. Die Vorteile einer solchen Vorselektion über biografische Fragen bestehen gegenüber dem klassischen Interview neben der größeren Objektivität offensichtlich in der höheren Wirtschaftlichkeit – nur die Bewerber oberhalb eines Cut Offs gehen in das klassische Interview. Die Validität wurde hinreichend nachgewiesen (etwa Ployhart et al., 2006).

Eine Herausforderung besteht darin, dass die Items anfällig gegenüber „Faking“ sind – Bewerber können schlicht falsche Angaben machen. Der Autor Schwall (2014, b) stellt dazu eine Lösung vor. Die biografische Frage nach der Erfahrung mit Projektgruppen wird ergänzt, indem die Bewerber bei den Antwortvarianten b, c und d gebeten werden, die jeweiligen Projekte kurz zu beschreiben. Alleine die Befürchtung, dass diese schriftlichen Ausführungen kontrolliert werden können, soll Bewerber dazu bringen, ehrlicher zu antworten. Der Autor stellt eine weitere Innovation vor, wie die Ehrlichkeit weiter erhöht werden kann, ohne manuellen Aufwand zu produzieren: Die Antworten auf die offenen Fragen werden automatisiert nach Stichwörtern ausgelesen. So bestand etwa ein Erfahrungswert darin, dass bei den Antworten auf die Frage nach den Projekterfahrungen bei den schwächeren Bewerbern häufiger das Adjektiv „schwierig“ auftauchte. Ergebnis der Studie: Durch dieses simple Auslesen von Stichwörtern konnte zu 71 % die Selbsteinschätzung der Bewerber korrekt vorhergesagt werden. Das erscheint zunächst zu niedrig. Die Idee besteht jedoch darin, nur den geringen Teil von Bewerbern zu interviewen, bei dem die Selbsteinschätzung hoch ist, die Antwortmuster jedoch eine schwächere Bewertung nahelegen, also vermutet werden kann, dass die biografischen Fragen nicht ehrlich beantwortet wurden.

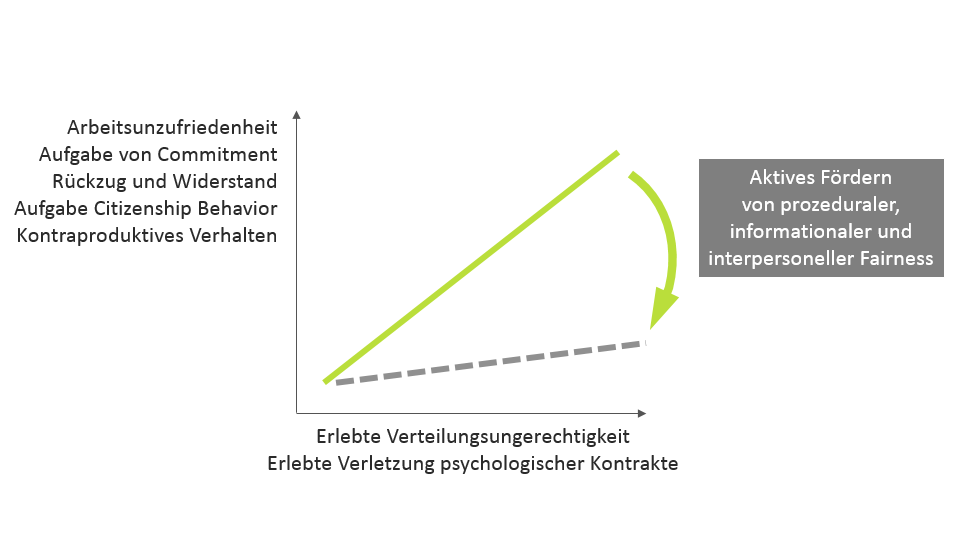

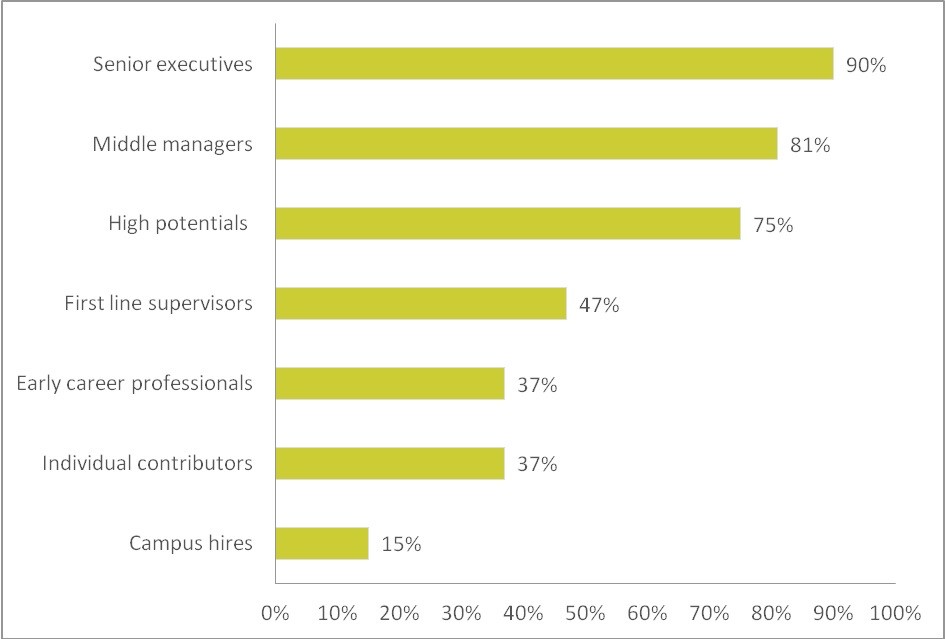

Stand der Dinge zur Interviewführung

Relativ zur praktischen Bedeutung hält sich der Umfang von Validierungsstudien zum Interview in Grenzen. Der führenden US-Autor Michael Campion von der Purdue University fasst die aktuelleren Studien zusammen (Campion, M., 2014). Er berichtet von bisher 36 durchgeführten Validitätsstudien. Zunächst gibt es die bekannten Ergebnisse, dass „Vorstellungsgespräche“ mit beliebigen Fragen ohne Anforderungsbezug („Warum möchten Sie bei uns arbeiten?“, „Was sind Ihre Stärken und Schwächen?“) trotz der Selbstgewissheit des Interviewers keine Validität haben und primär gegenseitige Sympathie sicherstellen. Der Treiber für Zuverlässigkeit und Treffsicherheit besteht in einer hohen Strukturierung durch anforderungsorientierte, vorbereitete Fragen in gleicher Reihenfolge.

![Bild3]()

Zum Thema Nachhaken war bisher Stand der Dinge die STAR-Methode, die wir auch in unseren Interviewtrainings üben (Situation, Task, Result). Hierzu gibt es Neues: Nach Campion bedroht das Nachhaken stark die Objektivität und am Ende die Treffsicherheit der Interviews. Professionellen Interviewern gelingt es kaum, so nachzuhaken, dass nicht am Ende die Bewerber mehr oder weniger deutliche Hinweise auf die gewünschte Antwort bekommen.

Er schlägt eher vor, für jede Frage allgemeine Nachhakfragen vorzubereiten (z. B. bei situativen Fragen: „Okay, und wenn Ihre Antwort nicht funktioniert, was würden Sie dann tun …?“ oder bei biografischen Fragen: „Welche Unterstützung hatten Sie dabei?“ oder „Wer war noch beteiligt?“).

Die höchste Validität weisen Interviews auf, in denen es vorbereitete Antwortkategorien gibt. Die schwächste Variante ist eine allgemeine Likert-Skala (z. B. 3 = erfüllt in der Antwort teilweise die Erwartungen). Besser sind Verhaltensanker, in denen etwa in drei Stufen die erwarteten Antworten inhaltlich beschrieben werden. Objektivität und Validität fallen eindeutig aus, die praktische Herausforderung ist es, die beteiligten Führungskräfte dazu zu bringen, diese tatsächlich zu nutzen. Dazu sollte es in der Vorbereitung Kalibrierungsübungen mit Videobeispielen geben.

Neues zu Situational Judgement Tests

In Situational Judgement Tests (SJT) werden Bewerbern berufliche Situationen mit der Bitte vorgelegt, sich unter einer von mehreren Alternativen zur weiteren Vorgehensweise oder Lösung der Situation zu entscheiden. Neben textbezogenen Itemformaten sind in den 90er-Jahren Varianten mit Bilderszenen und seit den 2000er-Jahren Varianten mit Videostimuli entstanden. Die in der Literatur berichteten Validitäten sind sehr unterschiedlich, die Zusammenhänge der SJT-Ergebnisse zu Vorgesetzteneinschätzungen variieren zwischen r = -.05 und r = .33, sodass es darauf ankommt, wie die SJT im Detail konstruiert werden.

Obermann Consulting hat dieses Jahr ein Projekt im Einzelhandel betreut, bei dem im Rahmen einer Potenzialanalyse Mitarbeitern 40 videobasierte Szenen aus dem Führungsalltag vorgelegt werden. In der Validierungsstudie vorab zeigt sich ein signifikanter Zusammenhang zur Vorgesetzteneinschätzung, sodass der SJT nun in Anwendung kommt. Durch die Darstellung von praktischen Szenen aus dem Berufs- und Führungsalltag haben die SJT eine sehr hohe Akzeptanz bei Bewerbern und im Management. Neben der höheren Akzeptanz liegt der Vorteil der videobasierten Stimuli darin, dass durch den visuellen Kanal der „kognitive Overload“ geringer ist und die SJT kein verkappter Intelligenztest sind.

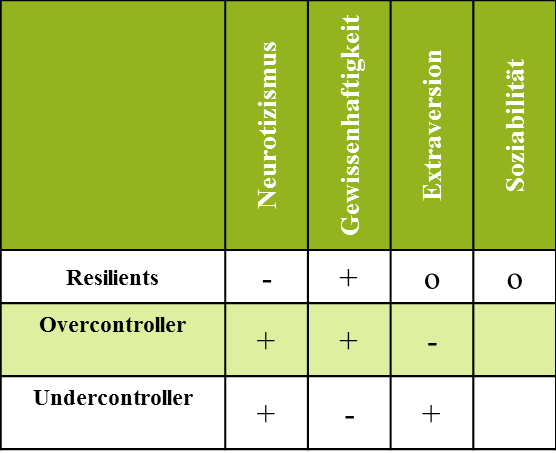

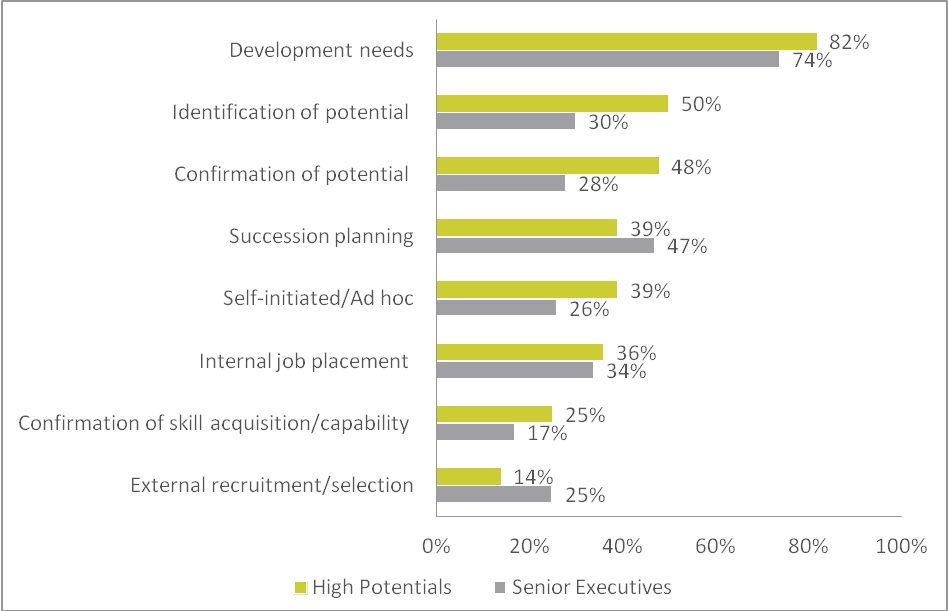

![Bild4]()

Situational Judgement Test – aufwändig aber effektiv

Auch dazu gibt es neue Studien. Barron et al. (2014) von der amerikanischen Air Force gingen zunächst den anderen Weg, um den Aufwand in der Erstellung der SJT zu reduzieren. Hier wurde sowohl auf Bildmaterial verzichtet als auch auf die Darbietung von (aufwändig zu konstruierenden) Antwortalternativen. In dem Air Force SJT wurden u. a. Kriterien wie Leadership, soziale Fähigkeiten und ethisches Verhalten getestet. Zwei SJT-Formen wurden dann an der gleichen Population getestet – Text-SJT mit mehreren Antwortalternativen und lediglich einer Antwortmöglichkeit (Frage: „Wie wahrscheinlich ist das hier beschriebene Verhalten in der Situation?“). Die Ergebnisse sind eher ernüchternd: Durch die Vereinfachung sinkt die Reliabilität von r = .91 auf r = .72. Die höchste Validität besitzt die vereinfachte SJT-Form mit Kriterien wie „Interesse an Kunst“ bei den getesteten Soldaten. Fazit: Eine zu große Vereinfachung erscheint nicht sinnvoll.

Den umgekehrten Weg beschreiben Fix & Ablitt (2014). Für die englische Bank Barcley’s wurden SJT mit einer rein verbalen Beschreibung und inhaltlich gleichen Videostimuli verglichen. Für die videobasierten Items wurde ein substanzieller Aufwand betrieben: Professionelle Schauspieler, animierter Hintergrund, 18 Monate Entwicklungszeit, Präsentationsperson einleitend zu den Videos. Beide Varianten führten zu ähnlichen Validitäten gegenüber der Vorgesetzteneinschätzung der eingestellten Bewerber (Textversion r = .19, Videoversion r = .18, jeweils signifikant). Der erhebliche Mehraufwand für die Produktion der Videostimuli scheint sich bezogen auf die Vorhersage von Joberfolg also nicht zu lohnen – anders zu betrachten ist die höhere Attraktivität für die Teilnehmer und die Akzeptanz im Management.

Literatur:

- Barron, L. G., & Cody, B. C. (2014). Comparative Validity of Traditional (Multiple Response) and Single Response Situational Judgement Test. Honolulu: SIOP, 29th Annual Conference.

- Campion, M. A. (2014). How to Develop Interview Questions and Anchored Rating Scales. Honolulu: SIOP, 29th Annual Conference.

- Conte, J. M. (2014). Perspectives on High Potential. Honolulu: SIOP, 29th Annual Conference.

- Cooper, D. A., & Slaugther, J. E. (2014). Reducing Workers Compensation Costs: The Influence of Implementing Integrity Testing. Honolulu: SIOP, 29th Annual Conference.

- Fix, C., & Ablitt, H. (2014). Made to Measure? Comparing Psychometrics of Text & Media-Based SJT. Honolulu: SIOP, 29th Annual Conference.

- Hendricks, D. A., Robie, C., & Laurier, W. (2014). Use of Other-Ratings and Technology to Address Applicant Faking. Honolulu: SIOP, 29th Annual Conference.

- King, D., Ryan, A. M., & Kantrowitz, T. (2014). Mobile and PC Delivered Assessments: Comparison of Scores and Reactions. Honolulu: SIOP, 29th Annual Conference.

- Kinney, T. B., Lawrence, A. D., & Luye, C. (2014). Understanding the Mobile Candidate Experience: Reactions Across Device and Industry. Honolulu: SIOP, 29th Annual Conference.

- Landers, R. N., Cavanaugh, K. J., & Proaps, A. (2014). Talent Management Using Mobile Devices. Honolulu: SIOP, 29th Annual Conference.

- Lievens, F., & Sackett, P. R. (2006). Video-based versus written situational judgment tests: A comparison in terms of predictive validity. Journal of Applied Psychology, 91 (5), 1181-1188.

- Meade, A. W., & Papparlardo, G. (2014). Development of an Efficient and Faking-Resistant Rapid Response Assessment Method. Honolulu: SIOP, 29th Annual Conference.

- Ones, D. S., Wiemik, B. M., & Schmidt, F. L. (2014). Cross-Cultural Validity of Preemployment Integrity Tests: A Transcultural Meta-Analytic Investigation. Honolulu: SIOP, 29th Annual Conference.

- Pickering, D., & Foster, H. (2014). Examining Relationship Between Employee Reliability and Job Performance for Managers. Honolulu: SIOP, 29th Annual Conference.

- Ployhart, R. E., Schneider, B., & Schmitt, N. (2006). Staffing organizations: Contemporary practice and theory, 3rd ed. Mahwah: Lawrence Erlbaum Associates Publishers.

- Schwall, A. R. (2014). Preventing Faking in Biodata Items Using Elaboration and Machine Learning. Honolulu: SIOP, 29th Annual Conference.

- Voss, B. E., Alshanski, S., & Christiansen, N. (2014). Convergence and Discrimination of Observer Personality Ratings From Work Simulations. Honolulu: SIOP, 29th Annual Conference.

The post Neue Forschungsergebnisse aus der Eignungsdiagnostik appeared first on Obermann Consulting.